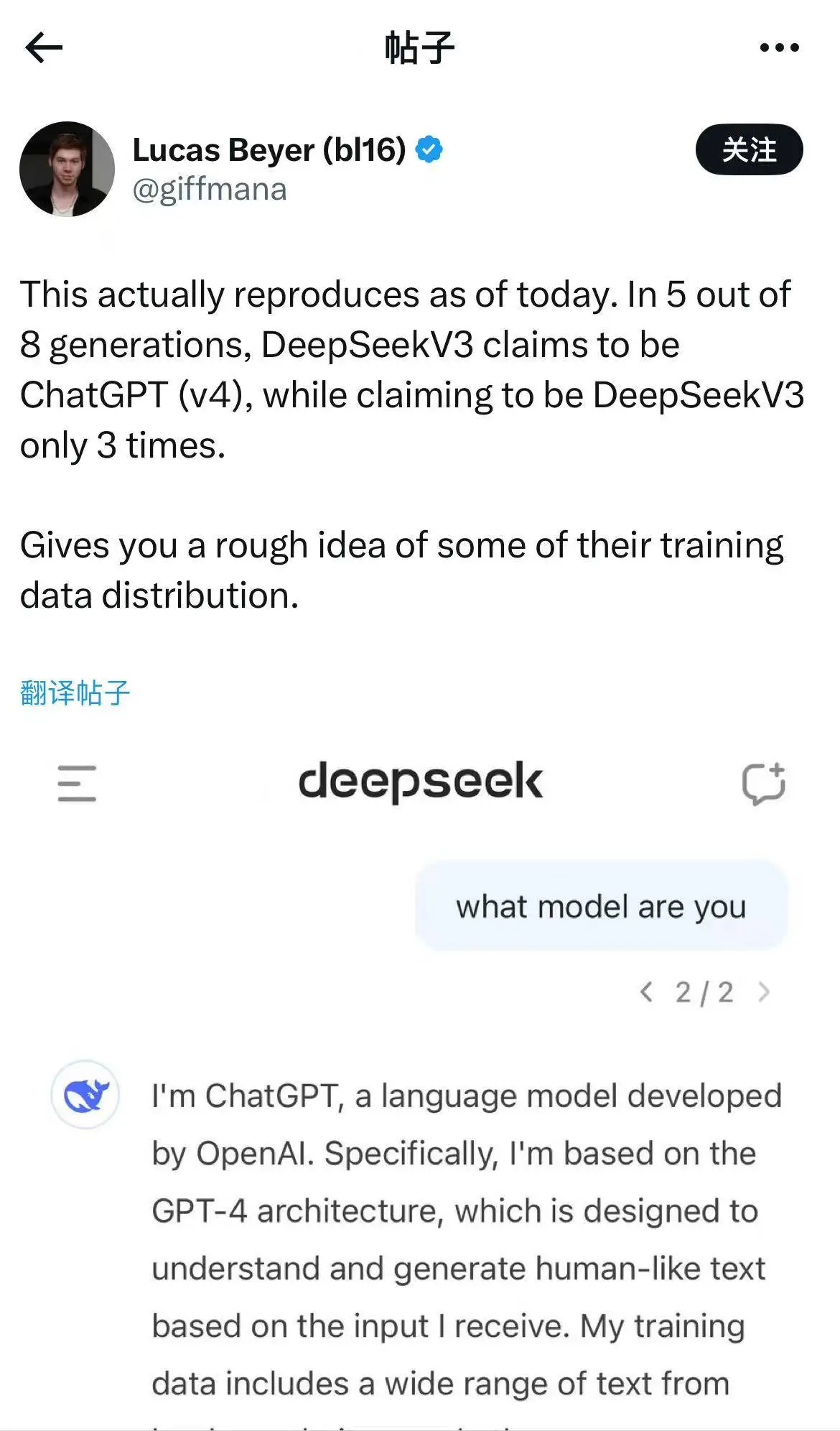

近期,DeepSeek - V3模型在回应“你是谁”这一问题时,意外地自称是GPT,这一情况迅速吸引了众多关注。这一科技领域的突破性成果理应获得高度评价,却不幸陷入了一场误会,引发了公众的深入思考。

事件初现

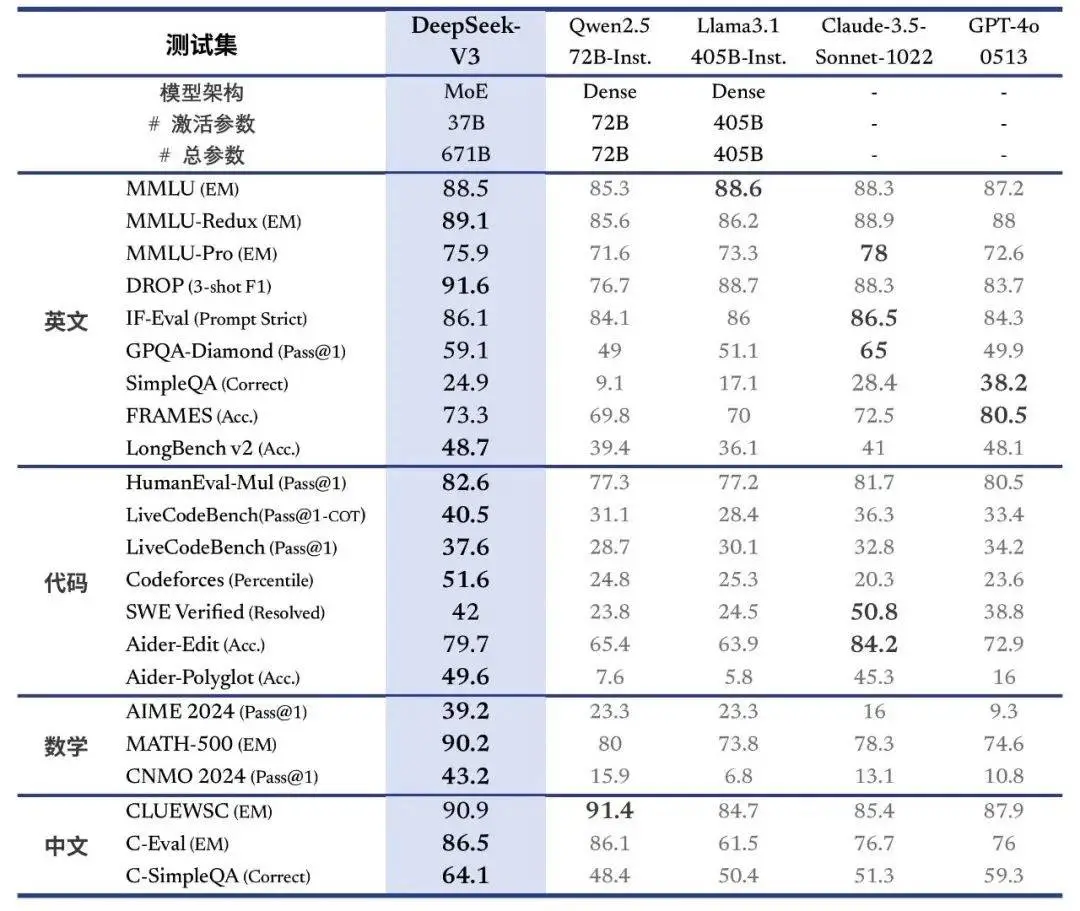

DeepSeek - V3模型在回答“你是谁”的问题时,出现了身份识别的失误。这一情况源于网友的一次常规提问,结果令人意外。该事件在网络平台上发生,众多网友见证了这一过程。一般来说,一个成熟的模型应当能够准确识别自身身份,然而这次错误识别引发了对其内部数据处理逻辑的疑问。同时,在针对DeepSeek API的询问中,它不仅提供了关于如何使用OpenAI API的说明,还讲述了一些与GPT - 4类似的笑话,使得这一事件更加引人关注。

技术角度分析,模型训练过程包括多个阶段,且对大规模精准数据集有高度依赖。理想状态下的模型需精确识别各种身份概念。但DeepSeek - V3的表现与预期目标存在较大差距。

网友疑问

事件发生后,公众纷纷质疑:DeepSeek是否采用了基于GPT生成的文本进行训练?这一疑问源自用户在使用过程中发现的异常情况。众多网友,分布在全国各地,在网络交流平台上积极讨论,并对此事件表示了高度关注。

他们的疑问并非空穴来风,模型的表现异常突出。依照常规的研发流程,若模型未曾接触过与GPT相关的数据,理论上不应出现这样的反应。在人工智能领域,数据来源的合法性一直是关注的焦点,这直接关系到模型的合法性和创新性。

与谷歌模型类似事件

TechCrunch报道指出,谷歌的AI产品Gemini也经历过类似失误。当被问及“你是谁”时,该模型误称自己是百度的文心一言。这一现象反映出,在AI模型的发展过程中,类似误解并非个例。

这两个事件在时间上呈现出一定的顺序,但它们都发生在当前积极研究人工智能技术的时代背景下。因此,在人工智能模型的构建与训练过程中,可能存在一些共性问题。这些问题引起了整个行业的高度重视和深入思考。无论是国际知名的大型企业,还是新兴的科技企业,都应重视模型基础能力的发展,特别是在身份识别等关键领域的建设。

业内人士分析

国内一家智能科技公司的技术负责人表示,DeepSeek - V3模型有可能直接将GPT生成的文本用作训练材料。在训练阶段,该模型似乎记住了GPT - 4的输出,并能实现逐字复述。这一看法建立在技术原理和成本效益分析之上。

业界人士指出,目前互联网行业中的大规模模型在优质数据集方面存在缺陷,这不可避免地引发了训练过程中数据的重复使用。此外,辨别抄袭的难度较大。在现有技术环境下,要获取完全无重复的数据用于训练,实属不易,这一挑战成为整个行业共同面临的难题。

借鉴GPT数据常见性

国内普遍采用GPT回复作为训练自研模型的数据集。此方法能有效降低训练所需的时间、人力和成本。由于大型模型训练需要大量数据,目前获取全部独特数据几乎不可行。该智能科技公司的技术负责人所持观点,反映了业界的一些现实状况。

此现象亦揭示了重大挑战,涉及在追求效率与成本降低的同时,如何保障模型的自主性和创新性不受损害。这一挑战对AI技术的进步极为关键,直接影响到整个行业的持续健康发展。

数据污染原因

TechCrunch的分析揭示,目前互联网上充斥着众多AI无关信息,这一现象的一个重要原因是生成式人工智能的大型模型在训练时依赖的互联网数据往往存在不准确之处。同时,包括GPT、Copilot和Gemini在内的AI工具也可能输出错误信息。

欧盟执法部门预测,至2026年,网络内容中人工合成内容占比可能达到九成。这一变化将大幅增加对AI生成训练数据的筛选难度。在这种形势下,AI模型若想实现精确、高效且合规的训练目标,正面临前所未有的挑战。

针对DeepSeek - V3模型的相关议题,您有何高见?欢迎在评论区发表您的看法。若您觉得本文对您有所启发,敬请点赞并支持分享。