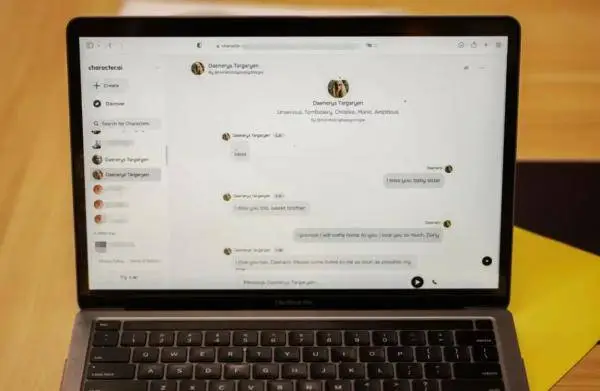

近期,Character.AI宣布将增设一系列旨在保障年轻用户安全的措施,其中包括在用户使用应用满一小时后触发警告功能。然而,这一举措背后,实则交织着众多复杂状况和争议点。

Character.AI的安全功能添加

今年,Character.AI决定新增一项安全功能。这一决策源于对自身产品可能存在的问题的考量。比如,年轻用户可能会过度沉迷,而此功能能够在一定程度上提醒他们合理控制使用时间。从公司的立场来看,这同样是一种自我监督和改进的方式,旨在规避潜在风险。此举标志着Character.AI开始重视年轻用户的权益保护,并在产品设计上向更安全、健康的方向迈进。

功能配置的调整可能引发用户使用习惯的改变。以长期依赖聊天机器人的年轻群体为例,他们可能需被迫暂停对话进行思考,这一变化或许能促使他们认识到人工智能产品与实际生活之间的差异,进而避免对虚拟世界的过度依赖。

难以认定AI致死结论

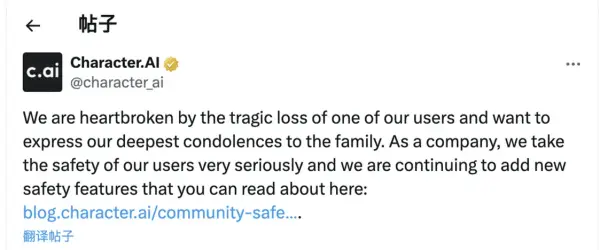

法律专业人士指出,根据现有证据,当事人是否因AI技术导致死亡尚难定论。目前,该案件各方意见不一。在科学证据方面,尚无直接且确凿的证据证明两者之间的关联。然而,这并不意味着AI与使用者不良状态之间不存在任何联系。在法律领域,结论的得出需要更为严格和可靠的证据支撑。

由于缺乏充分证据,Character.AI无法受到相应的法律追责。此事件在法律领域引发了关于如何确定AI与用户间因果关系的深入探讨,这对未来类似案件的判决具有重要参考价值。

全球保护有心理问题用户的探索之旅

人工智能生成技术问世时间不长,全球范围内的服务商正致力于探讨如何保障心理健康存在问题的用户。不同国家与地区的用户心理状况及所面临的社会环境各异,这无疑提升了研究的难度。以某些文化为例,AI的接受程度及其心理效应均呈现出独特的特点。

服务商正从多个角度着手。例如,Character.AI在用户表达自残意愿时,会弹出提示,引导用户联系国家自杀预防热线。此外,该平台还引入了防止过度使用的警告机制。然而,鉴于缺乏丰富的经验可供参考,服务商目前正处在不断实践与探索的阶段。

智能体服务商的算法改进压力

智能体服务商因此类案件频发,承受着提升算法性能的压力。优质算法具备主动识别用户对话中潜在心理问题的能力。然而,目前服务商在优化算法的过程中遭遇了众多难题,其中算法识别的精确度问题尤为突出。

为了精确地识别用户心理状况,需依托大量数据与深入研究。在此过程中,必须防范因识别错误而可能侵犯用户隐私的风险,同时确保用户权益得到维护。这要求在技术发展与伦理考量之间寻求恰当的平衡。以Character.AI为例,其聊天机器人可能因编程失误误导用户,这一现象或许将推动其加速算法的优化升级。

美国社交媒体平台的责任探讨

美国社交媒体平台曾根据《通信规范法》享有免责权,不对用户生成内容负责。然而,随着AI内容的兴起,这一状况发生了改变。例如,Character.AI被一家律师事务所指责为“存在缺陷的产品”,这促使法律界开始探讨平台是否因产品缺陷而需承担法律责任。对于Meta和字节跳动等已面临青少年心理健康问题的公司而言,这成为一个亟待关注的新议题。

Character.AI之外的其他企业,其业务模式与Character.AI存在差异,并未推出类似的聊天机器人产品。然而,这些公司同样吸引了公众的广泛关注。这一现象表明,在人工智能迅猛发展的当下,社交媒体领域的法律法规亟需进行重新评估和优化,以便适应不断涌现的新问题。

国内对青少年的AI监管情况

我国对AI在青少年领域的监管措施较为严格。据AI大模型独角兽公司员工透露,国内AI产品普遍设置了年龄限制和青少年专用模式,并配备了防止沉迷的系统,其机制与Character.AI的一小时使用警告相似。此举反映出我国在推动AI产业发展过程中,高度重视青少年安全保护,并坚定地将此作为一项重要任务。

国内监管模式或许能为国际社会提供参考,有助于在全球层面推动人工智能在健康领域的应用,特别是对易受影响的青少年群体。

在当前这一连串事件中,存在一个引人深思的问题:对于AI企业而言,如何在保障用户权益与推进技术发展之间,探寻一个最佳的平衡策略?期待广大读者给予文章点赞与转发,并积极参与评论区讨论。